01012020 life

この動画をなにげに眺めていたらMade in Abyssを見なくてはいけない気分になったので、一気に見てしまった。

これはよいですね。二期も楽しみ

01012020 life

この動画をなにげに眺めていたらMade in Abyssを見なくてはいけない気分になったので、一気に見てしまった。

これはよいですね。二期も楽しみ

01012020 bioinformatics

DNA修復

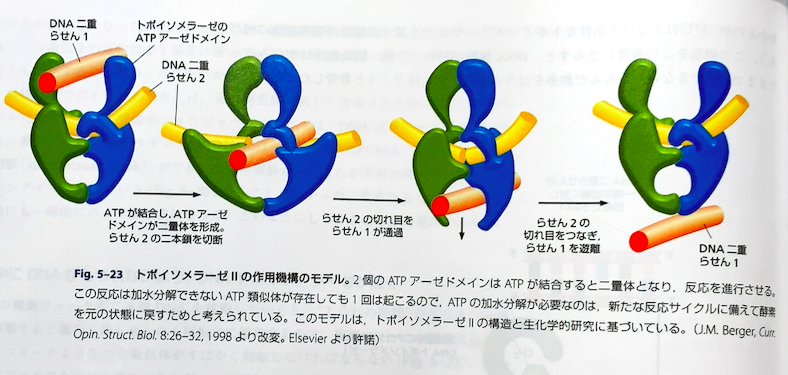

TOPIIは私が初めて関わったSBDDプロジェクトなので興味深い対象だ。そして生物学の描像って結構物理学とか無視したいい加減なもんなんだなーと思った最初のターゲットである。

以下はその当時のTOPIIのメカニズムの説明として全く同じものであるが、「こんなハサミみたいにパカパカ開くメカニズムだったらヒンジの部分固くないといけないしエネルギーももっといるし無駄遣いやん」と思っていた。

その当時は1BGWしか知られていなかったのと、割と単純な対象な阻害剤と変異株の実験から同定された作用部位(ヒンジのとこ)から構造的なメカニズムを調べるということをやっていた。

あーでもないこーでもないと悩んだ結果ねじれる感じで切断するんではという結論に至った。それなら阻害剤がワークする理由もきちんと説明できるし。

が、SARがスティープ過ぎてちょっと置換基入れると阻害活性消失するという状態で、プロジェクトはまもなく中止になったのだけど、そのあとDNAとの複合体が解かれて、「私の予想で合ってるじゃん」と嬉しくなったのであった。

01012020 life

今年を振り返ってみる(下書き時はまだ20191231)。エントリアップロード数は去年同様100弱であった。

SBDDのチームは全員依頼講演がくるくらいには認知度が上がったので良かったなと。一方で、海外での認知度挙げないとトップラボとのコネクションもつくれないよねーってことでそのあたりをどうするのかが来年の課題だろうなというのは認識しています。あとはオープンソースのプロジェクトにも積極的に貢献していけるといいなと。

それから、今年からバイオインフォマティクスのグループを兼務するようになって、最初は(インフォマティクス側の)お手伝い要員くらいに軽い気持ちでジョインしたんだけど、だんだんそうも言ってられなくなったというかちょっと真面目にやらんといけなくなったので、後半はちょっと真剣に取り組むようにしたつもりです。来年はなにかいい成果をだして学会発表に持っていけるようにしたいですね。

来年あたりは構造バイオインフォマティクス的なアプローチで新しいMoAとかKey-Lockシステムを超えた機序での薬剤探索にチャレンジできれば嬉しい。

今年はあまりコードが書けなかったので、来年はもう少し書きたい。あとはちょっと地域のコミュニティに顔を出す頻度を高めたい。それから海外のPyConでなにか発表してみたいかな。来年のPyCon APACはコタキナバルですよ。

PyCon APAC 2020 will be held in Kota Kinabalu, Sabah, Malaysia! See you on 19th-20th September 2020.

— PyCon MY (@pyconmy) December 17, 2019

31122019 bioinformatics

30122019 bioinformatics

タンパク質の章

生物学の説明一般に言えるんだけど、抽象的すぎてよくわからんことが多い。

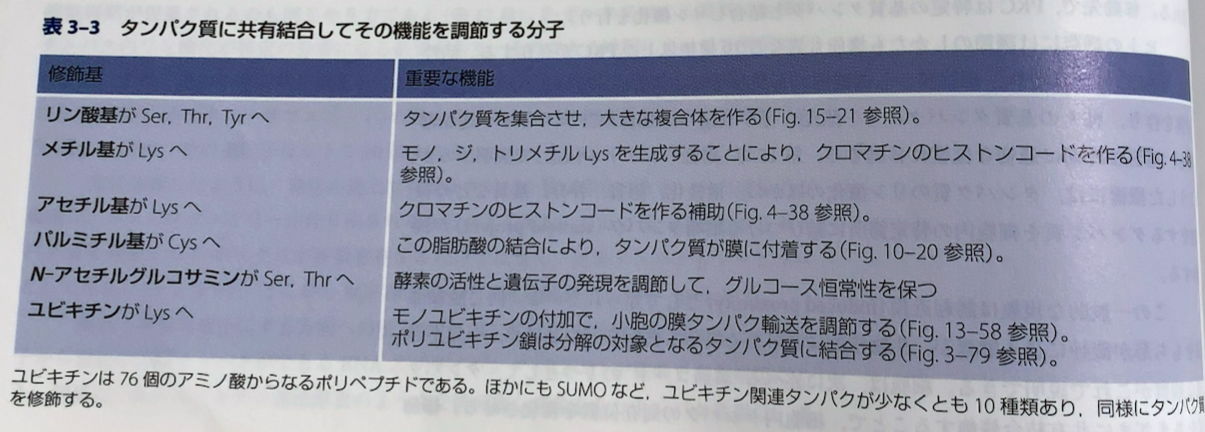

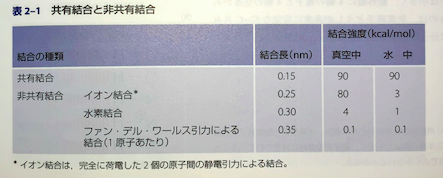

例えばリン酸基についても2章で述べられているように水溶液中ではイオン結合や水素結合力って急激に減衰するはずなのに、リン酸基が溶媒側の残基に付加することでコンフォメーション変化が起こるとかそういう説明に持っていくのに違和感がある。「リン酸基は2価の陰イオンだから違うんやで」っていう理屈でもいいんだけど、その場合はどのくらいのエネルギー変化が期待できるとかそういう説明ほしかった。

あとちょっとの変化がとか書いてあるけど、ダイナミズムに対してどうなんかな?という疑問はつきまとってしまう。

LYSとメチル化が相性いいのはここで理解したからいいけど、アセチル化ってどういうエネルギー成分が支配的になってくるのか興味がある。

構造探すか。

29122019 bioinformatics

生物はどれも化学反応系にすぎない

化学反応の章だったのでほぼ理解していた。さくさく読み進んだ。

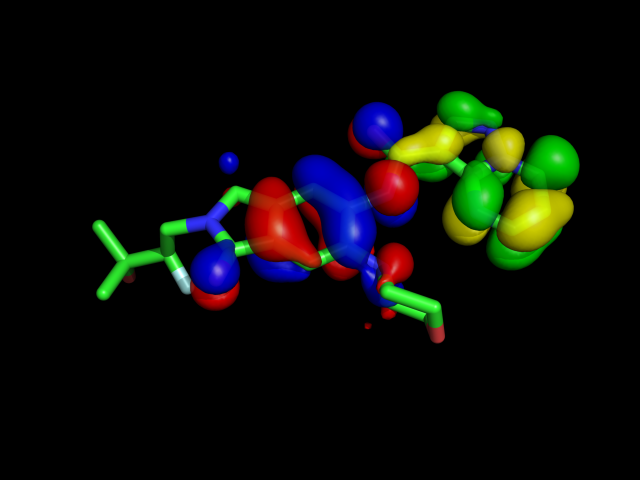

これの出典が知りたかったがわからなかった。FMOのES項をどれくらい補正すればいいのか知りたかったのだが

28122019 chemoinformatics

This is the 24th article of the Drug Discovery Advent Calendar (Dry) 2019.

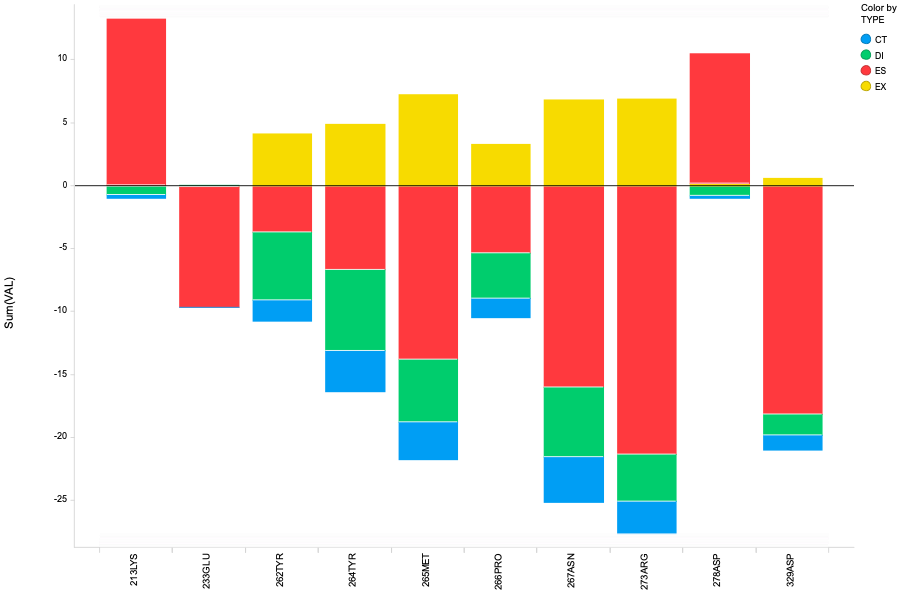

I was very impressed by the weak hydrogen bonds in the article, A C-H···O Interaction Against IRAK4 / Drug Hunter . So I checked that interaction with Fragment Orbital Method

PDB:6UYA was used as a complex structure and details of calculation are here

If you are not familiar with FMO, this book will help you.

Fragment Molecular Obital Method : Practical Applications To Large Molecular Systems [Hardcover] [Jan 01, 2009] Fedorov

Fragment Molecular Obital Method : Practical Applications To Large Molecular Systems [Hardcover] [Jan 01, 2009] FedorovThis is actually the article for the 24th advent calendar, but I can't give you this book because I'm not Santa Claus. If you click on the link instead, I'm sure that Amazon will deliver this book to you instead of Santa Claus.

What a wonderful Christmas gift it is! Now, click it!

The result is here. I only show the interaction which have strong stable/unstable interactions for clarify.

The result shows that there is a C-H···O Interaction between compound and protein(TYR264 in this case), but the interaction energy is rather weaker than the typical hydrogen bond.

*** The amino acid number and fragment number doesn't exactly match in FMO. The carboxylic acid moves to the next residue because of cleaverage in protein at C (sp3) -C (sp3) bond.

And also I'm not sure that the nature of this interaction is same as hydrogen bond. I guess it also includes side chain effects because DI term is slightly large. To clarify this, we can replace TYR with Gly and execute FMO calculation again.

Next, we will interpret it by frontier orbital, but it's WIP.

I guess we'll know a lot if I do it so far, but I've run out.

Have a happy new year!

28122019 life

11月の後半から12月の中旬までずっと学会に入り浸っていて、久しぶりの朝の富士山は雪の侵食がそうとう進行していた。

Repubrewに行ったら新たなビールが揃っていた。左の濁っているのがホップを過去最高に投入したHazyIPAだったと思う。右は忘れた。

その後忘年会が続き、二次会で豪快な肉を食べていた。若いっていいなと思いました。ちなみに学会出張と忘年会のコンボでやたらと身体が重くなったので年末は運動をしなければならない。

年末読書用の細胞の分子生物学も届いた。

先週土曜日に華味に昼を食べに行きつつ新年会の予約してきた。それまでずっと予約の電話をしてたんだけど、全然つながらないので、直接行ったほうがいいかなと。

頼んだのはラム焼き肉だが選択をミスった。美味しすぎて食べ過ぎたのがミス。ご飯おかわりしてしまったわ。

その後、昼ビール

日曜はずっと行きたいと思っていたヤシオスタンに行ってみた。

カラチの空まで歩いて20分。ポケストップもないから退屈です。連れ回してるランターンを撮ったらドーブル写り込んでた。

カラチの空ではビリヤニ

マトンのカレーとロティ。多人数で行ったほうが種類も楽しめて良い感じでした。色々注文したいものがあったのでまた行きたい。

知り合いのインド人に「ヤシオスタン行ったで」ってメールしたら「埼玉に住んでたけど、そんなん知らんかったわ。今度チェックするわ」と返事が来た。

27122019 life

3月のライオン 15

できないには

の2種類がある。

21122019 bioinformatics

細胞の分子生物学を書い直した。最新版の必要性は特に感じないので、コスパの良い第5版の中古にした。

昔は第3版を買って勉強したように思う、といっても流し読みだったが。