04032020 Python

PyCon mini Shizuokaお疲れさまでした。特にスタッフの方は急遽オンラインに切り替えたりして相当バタバタしたことと思いますので、本当にお疲れさまでしたとお気持ちを表明したい。

Blogに書くまでがカンファレンスだそうなので、なんか書いておきます。

偉そうにいうとアレなので、偉い方は言いましたが、カンファレンスはブログを書くまでがカンファレンスなので、

— Hiroshi Sano (@hrs_sano645) February 29, 2020

PyCon mini Shizuoka のブログレポートも書いてください!

(了承いただければ公式サイトにも掲載できればと思います)

自分ももちろん書きますw #pycon_shizu

さて私は表記の通りオンラインになったタイミングで発表を取り下げました。理由は単純でブロードキャストしたくないスライドがいくつかあったからですね。次回あればもちろんまた応募します(今度はネタ全開にしようかな)。

当日はyoutubeでオンラインでちょっと観戦しつつ、締切の迫っているPythonの洋書を翻訳していた。

そんな感じです。

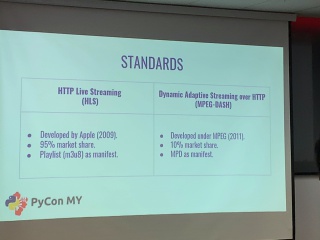

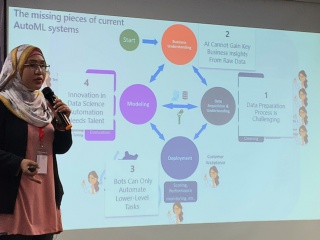

Pycon MYに行ってきたとか静岡アドベントカレンダーでも触れたんだけど、ローカルコミュニティは貴重なのでこれからも頑張って欲しいです。ただ、初心者の人とかの対応とか結構消耗していて、運営から離れちゃってる人を何人も見ているので、そのあたりもうまくやれたらいいですねーとは思います。

おまけ(駄文なので何も求めていない)

- 雑記 | #pyconjp 2019のトークはレベルが低かったのか? 〜台湾・シンガポールのPyConに参加して〜というエントリを読んでふむふむーと思った。

私は初めて「PyCon2019はいいやー」ってスキップした(それまでは海外出張がぶつかったのを除いて参加してる)。結局あの規模だとまぁそうならざるを得ないよねーくらいの感想で、レベルが低いというよりは参加者の満足度を優先したのだろうと考えていますし、それはそれで問題ないよねーと思う。レベルの高いトークももちろんあるし、パッケージ関連の話は毎回聞いていて勉強になっている。

ただ、私は今年もアジア圏のPyCon行くのを優先してもし都合が合えばJP行くかなーって感じ。でもローカルコミュニティとしてPyConJPに参加するのは面白いよなーとは思っている。2018のPyConJPで一番面白かったのはポスターだったしね。

PyConJPだって規模を小さくしてガチのヒトを濃縮すればトークのレベルは必然的に上がるけどPyConJPはそういう方向目指しているわけじゃないんじゃないかなーと思っているし、それでいいんじゃないかなーというのが私の見解。

パーフェクトPython (PERFECT SERIES 5)

パーフェクトPython (PERFECT SERIES 5)