02122018 bioinformatics 横浜

10年以上ご無沙汰していた分生に行ってきました。昔と比べてバイオインフォのセクション減ったよなーというような話をしたら、「バイオインフォなんて技術だから実際の研究の一部として使ってるからポスター散らばってるんだよ!」と言われて、一応全ポスターチェックしたら、確かに散らばっていたので、ポスターチェック大変だなぁと思った。ただ分生のアプリ便利だったので他の学会でも取り入れてほしい。

あとはバイオインフォやってた頃の元同僚とか知り合いとかに会えたので良かった。

一日目は昼くらいに横浜着になってしまったので、何も考えたくないときの定番のポルタの地下の麻婆豆腐のとこにいき、山椒の効いた麻婆豆腐麺を食べた。うまし。

夜は豚の味珍

やかん(焼酎ストレート)と足

頭と舌。舌は後から頼んだけどちょっと多かった。二皿が限界かな。

2日目はシェークシャックに。ハンバーガーは確かにうまいがポテトは重かった。 ハンバーガーだけでよかった。

夜景はきれい

ベアードでスモーク肉でも食べて帰るかと寄ってみたのだけど、まったく肉の気分ではなく ビールを一杯頂いて、ホテルに帰って仕事をしただけであった。夜は近所の揚州商人で軽めの ラーメン。

最終日は夕方までに帰らないといけなかったので、乗り継ぎ駅で家系ラーメン を食べた。菊名乗り換えだったらここもありかなと思うけど、家系ラーメン結構もたれますね。 右側は三島の乗り継ぎで30分くらい空いて暇だったので、果南ちゃんにサイン本をもたせてみた。

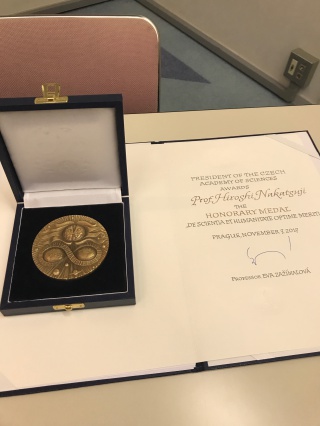

夕方いいことがあったので、リパブリューで軽く飲んだ。ポスター賞って学会の中で楽しむものなんかなと考えていて あまり重要視してなかったのだけど、細かいところまでわからない経営層にとってはものすごくわかりやすい指標らしく (社外からの評価ということになるので当然か、、)社内でも成果の一つとして評価されるみたいなので、社外発表する場合には積極的に狙っていくと良いと思います。本人のモチベーションにもなるしね。

基礎量子化学―軌道概念で化学を考える

基礎量子化学―軌道概念で化学を考える

言葉とは何か (ちくま学芸文庫)

言葉とは何か (ちくま学芸文庫) ビジョナリー・カンパニー 2 - 飛躍の法則

ビジョナリー・カンパニー 2 - 飛躍の法則