02112009 Scala

プレゼンの原稿考えなきゃいけないのだけど、すすまないので現実逃避

ScalaはPythonみたいなヒアドキュメントの仕組みが使える

object S_hizuo_cala {

def main(args : Array[String]) : Unit = {

println(""" 静

岡

静岡

静岡静

静岡岡

静岡静岡

静岡 富士宮

静岡静岡 富士宮 小山小山小山

静岡静岡 富士宮富士山御殿場小山小山

本川根静岡静岡静 富士宮富士御殿場御殿場

水窪本川根静岡静岡静岡 芝富士宮富士裾野御殿場

水窪水窪本川根静岡静岡静岡 川富士宮富士富士裾野裾野

水窪水窪水窪本川根静岡静岡 富士川富士沼津長泉裾野

水窪水窪本川根本川根静岡静岡静岡富士川富士沼津長泉三島函南

佐久間水窪中川根本川根静岡静岡静岡由比蒲原 沼津清水町三島熱海

佐久間春野春野中川根川静岡静岡静岡エスパルス 沼津韮山熱海

佐久間春野春野中川根根静岡静岡静岡静岡 沼津伊豆長岡熱海

佐久間龍山春野中川根川根静岡静岡静岡 沼津大仁大仁伊東

佐久間龍山春野川根川根藤枝ゴン静岡静岡 戸田修善寺中伊豆伊東

引佐天竜天竜森森森川根島田藤枝ゴン静岡 土肥天城湯ヶ島中伊豆伊東

引佐引佐天竜天竜森森金谷島田藤枝ゴン 土肥天城湯ヶ島中伊豆伊東

引佐引佐天竜豊岡森掛川金谷島田藤枝焼津 賀茂天城湯ヶ島伊東伊東

三ヶ日引佐浜松浜北森森掛川掛川島田藤枝焼津 賀茂西伊豆河津東伊豆

,,三ヶ日細江浜松浜北磐田掛川掛川空港吉田大井川 西伊豆河津河津東伊豆

湖西 浜松浜松磐田袋井掛川菊川榛原吉田 松崎松崎河津河津河津

湖西 雄踏浜松豊田磐田 大大東小笠相良 松崎松崎下田下田

湖西新居舞阪浜松竜福田浅須大東浜岡相良 南伊豆下田下田

.浜松洋福田羽賀大東浜岡相良 南伊豆

原発御前崎""")

}

}

参考

Make: Technology on Your Time Volume 08

Make: Technology on Your Time Volume 08

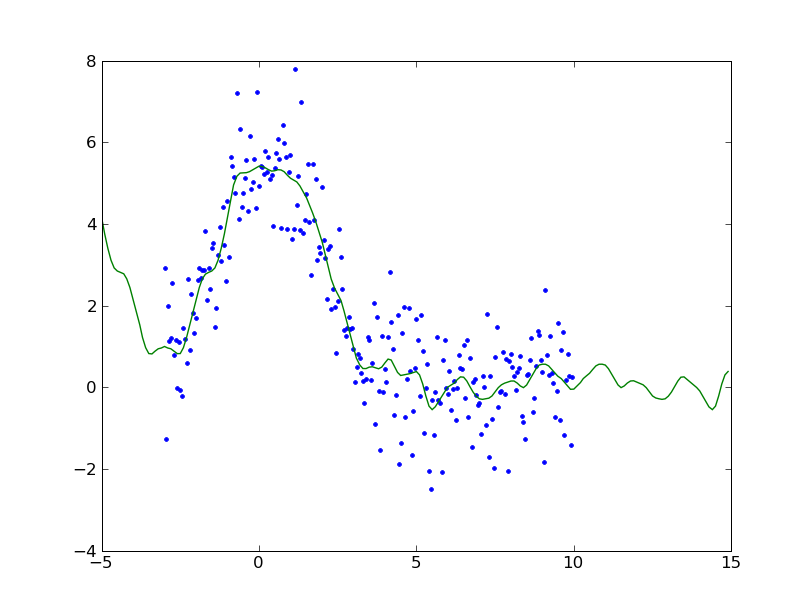

Machine Learning: An Algorithmic Perspective (Chapman & Hall/Crc Machine Learning & Patrtern Recognition)

Machine Learning: An Algorithmic Perspective (Chapman & Hall/Crc Machine Learning & Patrtern Recognition)

Pharmacokinetic-Pharmacodynamic Modeling and Simulation

Pharmacokinetic-Pharmacodynamic Modeling and Simulation

三文ゴシップ

三文ゴシップ