20102016 japanese

野崎洋光さんのおかゆの本。

水は米に対して10倍量、強火ではじめて沸騰したら弱めて20分、その後弱火で10分。必要以上に混ぜない。

気になったのは麺をおかゆ仕立てにするというもの。乾麺を短く折って麺100gに対して水500mlで煮る。その後水溶き片栗でとろみをつけるというもの。

気になったので昼ごはんとして乾麺の蕎麦でやってみたところ、大変美味しかったのでたまに作りたい。

20102016 japanese

野崎洋光さんのおかゆの本。

水は米に対して10倍量、強火ではじめて沸騰したら弱めて20分、その後弱火で10分。必要以上に混ぜない。

気になったのは麺をおかゆ仕立てにするというもの。乾麺を短く折って麺100gに対して水500mlで煮る。その後水溶き片栗でとろみをつけるというもの。

気になったので昼ごはんとして乾麺の蕎麦でやってみたところ、大変美味しかったのでたまに作りたい。

動態学会で発表してきたが、初めて参加したがわりとアウェー感があった。CBIなんかとは雰囲気が違いますね。内容あんまりわからんのにランチョンもなーということで、昼も夜も攻めたw

6年ぶりくらいに富士川に乗った。特急なのに三両編成。そして指定を取ったらスカスカなのにピンポイントでおっさんの隣に。

靴脱いでくつろぐのはいいんだけど臭かった。新幹線とかでもOLさんがヒール脱いでたりするけど、あれなんなんだろうね。OL(おっさんれでぃ)なのかな?w

途中僕が申請したポータルがポケストップになってた。

行ったとこ

佐倉の味噌ラーメン。悪くはないが味噌ラーメンは色々難しいと思う。そもそも味噌が美味すぎるんじゃないかな?

信州ゴールデン街は、せんべろ的な飲み屋なのかなと思って入ったんだけど、意外と若い人がやっていて、風な感じを醸しているだけでなかなか居心地は良かった。

土曜の昼はカレー。辛口ポークを頼んだけどインドカレーのほうが美味しそうだった。辛口ポークは甘酸っぱいんだけど唐辛子の辛さが結構くるというわかりやすいカレーだった。

十兵衛に行く前に、松本城をウロウロしてたら、ライトアップが始まって満月が登ってきたら、カメラマンが一斉にシャッターを切り出した。外国人観光客もかなりの数がいて、知っていたのか偶然なのか非常に気になった。いいカメラ抱えてたから知ってたんだろうなぁ。

で、十兵衛は6年ぶりです。今回新ルールが追加されていて

という。

このルールなんだかなーと思ったが、店の雰囲気は全然悪くないし、お店の方の接客は丁寧だし。何だこのルールは?とおもって調べたら、映画のモデルになったりロケで使われたらしい。しかも嵐、ジャニーズ。

ジャニオタ大挙して押し寄せたんだろうなぁ…

お察しですよw

エシャレット、馬刺し

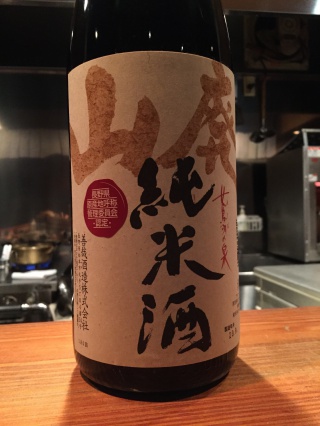

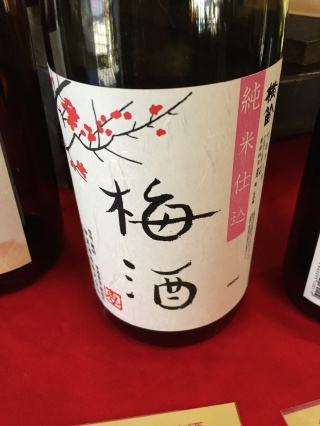

次の日は諏訪に寄って蔵めぐりをしてきた。

どの蔵も良かったが最後に真澄で〆た。

富士山五合目の東富士山荘でキノコ鍋をつつきながらジム壊してたらレベルが上がった。

前回から18日だから次回は一ヶ月後か

キノコ鍋はキノコがこれでもかというぐらい投入されているので、一度は行くのがいいと思う。来月上旬には山小屋締めちゃうしね。

キノコご飯は一回おかわりが可能

うどんときくらげの佃煮もついてる。

うどんも美味しい。

帰りにジムにラッキー設置してきた。いつ戻ってくるんだろうか?

13102016 life

ちょっと登りたくなったのでふらっと行ってきた。

展望台からと馬ノ背見晴台からの富士山。赤富士だ

勢子辻分岐。所要時間の案内が年寄り向けになっているのかな?

山頂、三回登って初めて晴れていた。

富士の方はちょっと霞んでいる。

富士山もあまり綺麗には撮れない。

久しぶりに山に登ってリフレッシュ出来た。次は浜石岳でも行ってこようかな

11102016 pokemongo

133種まで埋まった。

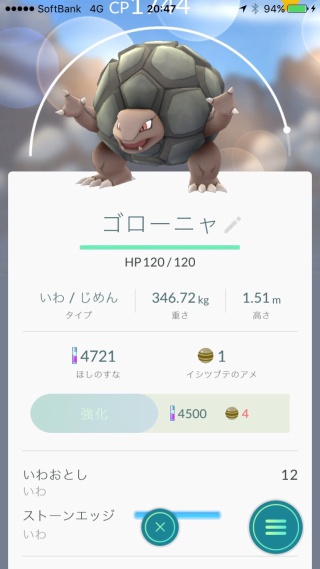

60km歩いて、下田産ゴローニャ

卵からパウワウ孵化してジュゴンに進化できた。オムスターもずっと飴48だったのが、昨日捕まえて進化できた。

今はベトベター連れて歩いているが60km歩けば進化できる。

取らなきゃいけないのはプテラ、エビワラー、サワムラー。

後は歩けばOK

フーディーンとカイリキーの価値が12km/匹っていうのが悩ましい。千本浜とか三保に行ったほうがコスパが良いのか…

カブトは割とそこら辺に出てるから後回しでよい。最後はヒトカゲ連れ回しながら10k卵を割るパターンなのかな。

10102016 pokemongo

雨が降り続いていたせいもあるんだけど、ジムも一気に崩されてちょっとやる気が削がれた。

そして5kたまごしか出ないのがムカつくw

さて、今日はちょっと暇だったので近所のレベル10ジムを更地にしてきた。ジムの面子はシャワーズ、カビゴン、シャワーズ、カイリュー、カビゴン、カビゴン、カイリュー、カビゴン、カイリュー、カイリューだったかな。このレベルのジムだと最低CPが2100を超えてくるので似たようなポケモンしかのってない。

というわけで最近のジムの上の方はカビゴンとカイリューしかいないのでそっちの対策だけしとけばいいけど、一人で解体作業はやっぱ時間かかる。

カイリュー2体/ラプラスって感じで、あとはゴルダック、ヤドラン、スターミーの氷技持ちをぶつければよい。シャワーズで連打するというのも有効かな。気分転換にプクリンとかのフェアリータイプをぶつけたりもよい。

カビゴンはシャワーズで連打。技2だけ避ければあまりダメージは受けない。破壊光線は避けやすいし、ゲージが貯まるのが時間がかかるのでやりやすい。のしかかりもさっさと避ければ高頻度で回避できる。

というわけで氷技持っているポケモンを育てるのと、シャワーズは強いのが多ければ多いほどよい。シャワーズ対策に草技x2のラフレシアやフシギバナがあるといい。

ラプラスもう一体欲しいなぁ。

10102016 沼津 chemoinformatics lunch

次回の日程と内容が大体決まりました。

今回はみんな大好きディープラーニングライブラリのTensorflowとkerasのハンズオンをすることにしました。

尚、お昼ガイドに載っている店ですが、朝早くこれるなら山正がおすすめです。一度くらいは並んでも食べに行く価値はあるかと思う。

僕は会場予約のついでに、リストの中で行ったことのない千楽北口に行ってみた。

カレーは洋食のカレーって感じで甘酸っぱ目のドロッとしたカレーです。でもカツが恐ろしい量なのであった。カレーが650円でカツカレーが1350円なのが納得というか、トンカツ厚すぎ… 満腹になるので気をつけたほうがいいかも。

あと、カレーの味から判断するに、カツハヤシのほうが満足感が高いかもしれない。

最近ご無沙汰だが、何年かぶりにお邪魔してきた。今回で最後かな。何年かぶりに一緒に飲む人や初めて飲む人がいて色々話せて楽しかった。

先付

ヒラメとあん肝

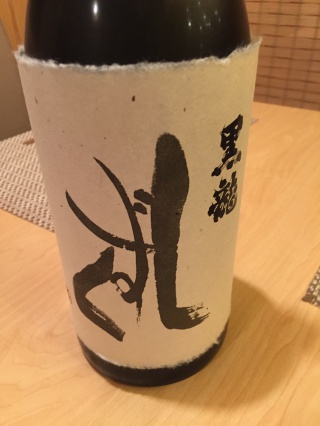

黒竜しずく、大吟醸は早めに飲むのがいいと思う。こってりした食べ物には合わないからね。

造りの三点盛り、左は白バイ貝。歯ごたえがよかった。

初亀のひやおろしにスイッチ

酢の物で口直し

牛肉と松茸

紀土

鰯煮。梅煮ではなかったと思うがさっぱりしていて美味しかった。

キノコご飯と吸い物

さらに寿司

巻物もつまむ

今回大幅な異動でみんなバラバラになっちゃうのと、それに伴って探索研究から離れるヒトが多い。 というわけで、なんかの機会に会うってこともなくなっちゃうのね。

最初に決定事項を。

次回のmishima.sykは12/10です。部屋を押さえてコンパス用意したらまたきちんと案内をだします。内容はtensorflowとkerasのハンズオンになります。今話題のDeepLearningですよw

というわけで、沼津の山正(ハナレ)で打ち合わせをしました。本店の方は予約が取れなかった

カマスの南蛮漬け(だったと思う)

左はイカにトロロが和えてあるもので、右はイイッコだそうです。シッタカとは違うらしいが区別つかんなぁ。先月南伊豆の民宿でいただいたイソモノとは違うんだろうなあと思いながら食べていたが、帰って調べていたら同じクボガイだった。

お造り。奥から時計回りに、かつお、アジ、カマス、マグロ、イカ。マグロは赤身が正解だと思います。

サンマ、美味

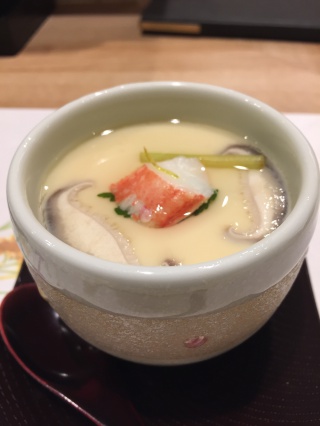

茶碗蒸し大好き。週末作ろうかなと思った

メカブと上に梅、混ぜて食べるとさっぱりしていて口直しによい。

天ぷらとかき揚げ。海老は頭が美味しいですね。天ぷら屋も行きたい、静岡の成生とか

最後はお寿司です。

コスパは高くておすすめだ。大変満足した。

次回のmishima.sykできたらランチに行けばよいと思うが、ランチは予約できないので、1030くらいから並ばないといけない…

先月の連休に親が来ることになり、親も義母もすっぽんを食べたことないそうなので、じゃぁすっぽんでもということで 季凛さんに久しぶりにお邪魔することにしました。

相変わらず美味しい。

マグロは大間産だったが一切れは娘に譲ったw 個人的にはマグロも牛肉も赤身のほうが好きですね。

すっぽんの生き血はリンゴジュース仕立てになっていたので非常に飲みやすかった。

すっぽんの刺し身は初めてだったが美味しい。特に赤身の部分がたまらなかった。

お鍋の登場でみなさんのテンションが上がったw

後ろ足の唐揚げは、フグの唐揚げのような味わいで美味だった。

鍋は美味しかった。

メインは雑炊なんだけど、それまで少食の老人のサポートをした結果、雑炊は3,4杯しか入らなかったw

デザートは一口食べて娘に譲った(そして雑炊をいただいたw)

いつも美味しい料理をありがとうございます。堪能しました。