今日からPyConMYだ、イェイイェイ。

書いていたらほぼ全て食絡みの話になっているので、PyCon my 2019の話は最後にちょっとだけ書きました。

朝は定番の漢記で鶏粥+揚げパンとアイスコーヒーを頼んでみた。

揚げパンさっと来た。

続いて粥、最後にアイスコーヒー(甘い)が到着

揚げパンを乗せていただく。

この後ちょっとお腹の調子が悪くなったのはコーヒーの氷のせいかなと疑った。

PyCon始まるまで辛かった。

行きは緑色の路線のMRTでTTDI駅まで行ったら歩いて10分弱が会場だった。

なんでAir Asiaがスポンサーなの?って疑問だったけど、スポンサーセッション聞いてたらなるほど!と思った。

ウェブサイトもアプリも使いまくったから大変勉強になった。

お昼ごはんも出た。テーブルで隣に座った方が、ローカルの方でRoR何年かやっていたらしい。

とか、他愛もない話をしていた。テーブルの向こうではデータサイエンスを仕事にするならマレーシアよりシンガポールのほうが賃金いいから移っちゃうよなーみたいな話もしていた気がする。

昼休みにコータスの影が出てたので外に出たらすぐ遭遇。天然物ゲット。

帰り道でニャンコ。

夕飯はオールドチャイナカフェでニョニャラクサ。

注文の際、「飲み物はどうすんだ?ビールは?ビールはのまんのか?オイ!」って聞かれたので、「ええ、まぁ」と。

ニョニャラクサはココナッツカレーヌードルで、ビーフンと黄麺が半分ずつ入ってた。

具材にかまぼこと油揚げが入っていて、中華とマレーの融合ですなとか偉そうなことを考えながら食べてた。

これはこれで美味しいが、もう少しナシレマを攻めたほうがよいのではないかという結論に達した。

食事も終了間際に、バチッと音がなってカウンターの付近だけ停電した。カウンターのレジ端末(WindowsXP?)は動いていたが、レシートの印刷やクレジットカード処理用のカードリーダーが使えなくなっていたので、海外のクレジットで払いたい勢は相当苛ついていた。私も15分近く待たされた。結局ビールとニョニャラクサで31RMだったのでビールはコンビニで買うのとそんなに変わらない値段であった。

帰り道にヒンズー教の寺院を見つけた

ホテルに戻ってきてから作業をしていて、ふと昨日の牛肉麺のところは明日は休みだから、汁あり食べておこうかなーと

のこのこでかけたら既に店じまいしていた。

ぶらぶら戻りながら、歩道橋があったので登って撮ってみた。ちなみにみなさん普通に横断するので、歩道橋を渡るという無駄なことをするやつなどいないw

帰りに、Kim Soya Beanで豆花(温)を持ち帰った。2RM(60円弱)なのでコスパは超良いが、豆腐屋の豆腐しか食べない私としてはこれをスーパー美味しいと表現することには抵抗がある。

夜食として毎日食べたいとは思う。

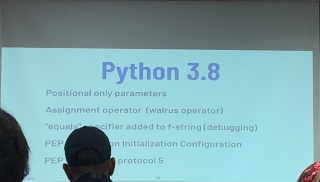

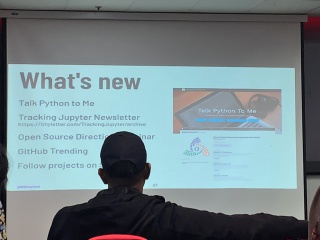

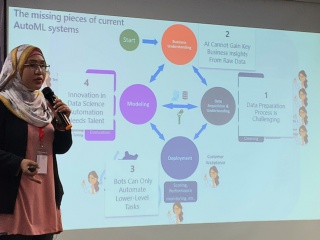

PyconMY 2019

PyconJPのように人が溢れているわけではないので、聞きたいセッションは確実に聞けるのは良かった。あとは全編英語なのも個人的には良かった。尚、参加者の中で日本人は私と今回演者として参加されたTakanori Suzukiだけであった模様。来年はどこかでなんか発表しようかなと思った(特にエアアジアのスポンサードセッションを聞いていて)。あとはLTようの小ネタくらい常に持ち運んだほうがいいだろうという。

Automate the Boring Stuff with Slackbot / Takanori Suzuki

Slackのボットを作る話。うちはSlackオルタネーティブを使っていて、創薬プロジェクト用のITSを作っているところなので、JIRAとボットの連携の話は大変参考になった。うちのボットは「疲れた」とか「死にたい」とかつぶやくと、「トキがストロングゼロを勧める」ボットしかまともに動いていないので、意味のあるボットを動かしたいところ。

Visualize the Black Box – An introduction to Interpretable Machine Learning / Rahul Bhatia

ブラックボックスになりがちな機械学習の解釈性を高めるためのライブラリを紹介していた。5つくらい紹介していたので、全部理解してうまく使いこなせるようにしたい。スライドアップされたら追記。

Air Asia 3.0

Air AsiaのITのほうのスポンサードセッション。

といっていて、非常に感銘を受けた。製薬インダストリーがヘルスケアカンパニーとかモバイルヘルスケアとかいいつつ、IT側を丸投げとか自社でどうにかするっていう発想がなく、製薬ペイ楽しみですねみたいな状況になっているのと全然違うなーと。

うちも、こういうのちゃんとやってITもまともな体制にして、プログラマーが楽しく仕事できるような会社になればいいなーと思った。

ウェブ進化論 本当の大変化はこれから始まる (ちくま新書)

ウェブ進化論 本当の大変化はこれから始まる (ちくま新書)