03102016 chemoinformatics 京都 deeplearning

土曜日は研究室出身者の集いみたいなのがあって参加してきた。下っ端なので気疲れはするけど楽しいし非常に勉強になった。皆さん活躍されているようで、スゲーって言うような仕事をしている方が何人もいて話していて刺激を受けた。僕も頑張らないとなーと思った。

Kさんのディープラーニング系の話で「ニューラルネットワークは結局脳の模倣だから、脳の理解つまり人間のシミュレーションの方向に進んでるとも言える。だから精度の良し悪しだけじゃなくそういった点も踏み込んでいくべき」みたいなことをおっしゃっていて、なるほどと思った。

機械学習ばかりやっている身だと精度のほうに気持ちが行っちゃうけど、もっと本質を追いかける必要はあるよなぁと改めて感じた。そして画像認識なんかは確かに人間の視覚情報処理の模倣とシステムの理解ということになるんだけど、僕が取り組んでいる創薬系でのDLは分子認識というタンパク質が低分子化合物を認識するというシステムの理解だからやっぱり、CNNとはまた違ったアーキテクチャを考え出すのと同時に、入力をどうするか(化合物の正しい入力表現)を考え出す必要はあるよなぁと感じたわけです。

あとは相変わらずN先生は頭良すぎて、さっぱり理解できんかったが、曰く「MO法は行き過ぎた理論」は名言だと思った。あんなに遠くまでデローカライズするようなMOというモデルは化学に沿っていないみたいなことを言っていて、ほうほうと思いながら聞いていた。隣の先輩に「僕もFMOを製薬業界に根付かせたいんですよねー」みたいなことをぼそっと言ったら「お前、そんな危険なチャレンジするのか!怒られるかもよ!!!」と返されたw N先生、何故かFMO大嫌いなんだよねー。FMOなんてMOがデローカライズそんなにしないからっていう経験則で分子を細切れにする方法論だから、「MO法は行き過ぎた理論」っていう考え方を取り入れて実務的に上手くやっている方法だと思うんだけどなぁ。今度どこが問題なのか聞いてみたい。

行きの新幹線の中で読んだ瀬尾まいこ

お昼は、高倉二条で蕎麦っぽいラーメンを食べてきた。酸味強め。つけ麺のほうが正解だったのか? わからん。

同窓会の懇親会。色々出てきて軽食をイメージしてたから面食らった。量も多くて途中でギブしたw

尚、楽友会館は学生時代住んでいたとこの近所だったので、懐かしさ倍増w

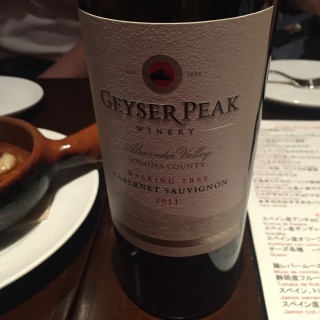

帰りに三条をぶらっと歩いてたら立ち飲みっぽいところがあったので入った。

ねぎ焼きってほんとにネギしか入ってなくてつまみにちょうどいい。生ビールも自分で入れる方式で外人の旅行者には受けるらしい。二階が民泊になっているらしく外人率が高かったが、フレンドリーな雰囲気の店で楽しかった。

それから、店員さんが高速バスの運転手もやっているらしく、御殿場の方まで行くことがあったらしく。地元ネタとかバスネタが聞けて楽しかった。

二日目は京都産ポケモンが少し欲しくて(今のバージョンはどこで取ったかが記録されるので、京都産10Kたまごが欲しかったw)祇園に鯖寿司を調達しに行くついでにイワークの巣となっているらしい丸山公園で一狩りしてきた。

が、暑すぎてとっとと退散w ハガネールに進化できるようになってから改めてイワーク狩りすればいいやw

疲れたので、おかるであんかけうどん。

とろみが葛かな? うまい、最高。

なんとなくよさげなラベルの日本酒を抱えて帰宅。

楽しかったのもあるけど、やはりすごく勉強になったなぁと思う。

深層学習: Deep Learning

深層学習: Deep Learning パターン認識と機械学習 上

パターン認識と機械学習 上 パターン認識と機械学習 下 (ベイズ理論による統計的予測)

パターン認識と機械学習 下 (ベイズ理論による統計的予測)