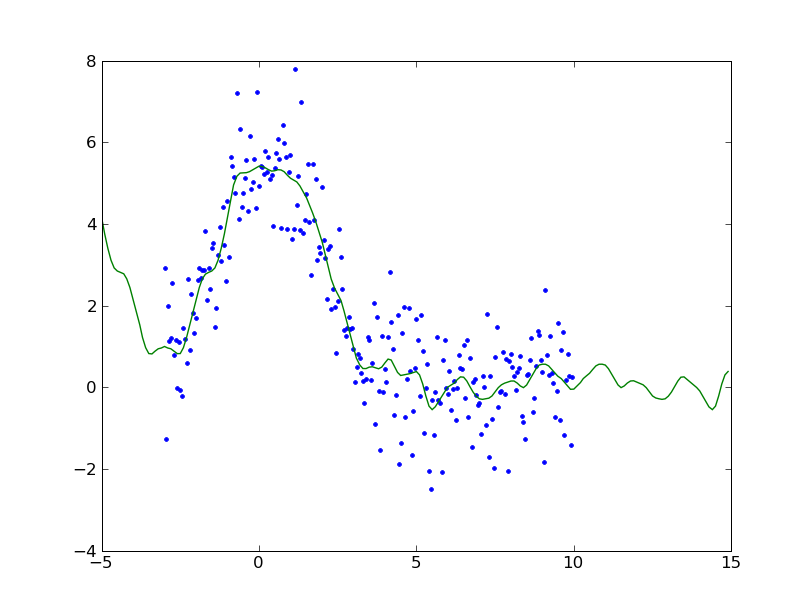

Machine Learning 3章

要するにbackwars phaseを実装すればいいんでしょ?的な。実際書いてみると逆に誤差を伝播している感がある。

# Code from Chapter 3 of Machine Learning: An Algorithmic Perspective

# by Stephen Marsland (http://seat.massey.ac.nz/personal/s.r.marsland/MLBook.html)

# You are free to use, change, or redistribute the code in any way you wish for

# non-commercial purposes, but please maintain the name of the original author.

# This code comes with no warranty of any kind.

# Stephen Marsland, 2008

# modifiled by kzfm 2009

from numpy import *

inputs = array([[0,0],[0,1],[1,0],[1,1]])

targets = array([[0],[1],[1],[0]])

ndata,nin = shape(inputs)

nout = shape(targets)[1]

nhidden = 2

beta = 1

momentum = 0.9

eta = 0.25

niterations = 10001

weights1 = (random.rand(nin+1,nhidden)-0.5) * 2/sqrt(nin)

weights2 = (random.rand(nhidden+1,nout)-0.5) * 2/sqrt(nhidden)

# train

inputs = concatenate((inputs,-ones((ndata,1))),axis=1)

change = range(ndata)

updatew1 = zeros((shape(weights1)))

updatew2 = zeros((shape(weights2)))

for n in range(niterations):

hidden = concatenate((1.0/(1.0+exp(-beta * dot(inputs,weights1))), -ones((shape(inputs)[0],1))),axis=1)

outputs = 1.0 / (1.0+exp(-beta * dot(hidden,weights2)))

error = 0.5 * sum((targets-outputs)**2)

if (mod(n,1000)==0): print "Iteration: ",n, " Error: ",error

deltao = (targets-outputs) * outputs * (1.0-outputs)

deltah = hidden * (1.0-hidden) * (dot(deltao,transpose(weights2)))

updatew1 = eta*(dot(transpose(inputs),deltah[:,:-1])) + momentum*updatew1

updatew2 = eta*(dot(transpose(hidden),deltao)) + momentum*updatew2

weights1 += updatew1

weights2 += updatew2

random.shuffle(change)

inputs = inputs[change,:]

targets = targets[change,:]

ちなみに、創薬系でのニューラルネットは論文とかは多いけど、実務ではあんまり使われないと思う(特にケミストよりになればなるほど)。というのは、実務においてはゴールするためにはこういうロジックで合成すればよろしいみたいな指針を提示しないといけないが、ニューラルネットでつくったモデルだとそういう解釈がしづらい。

なんか物がたくさんあって、フィルタリングしたいという要求には答えられるけど、何をどういう指針に従って創るかみたいな、創造(製造)律速な問題には使いにくい。

じゃぁ神経系は創造的ではないのかというと、それはまた違うんじゃないかなぁと思ったりもする。モデル化があれなのかなぁとも思うのだけど、、、、

みんなのPython 改訂版

みんなのPython 改訂版 The Definitive Guide to Pylons

The Definitive Guide to Pylons プログラミングHaskell

プログラミングHaskell The Definitive Guide to Pylons

The Definitive Guide to Pylons Machine Learning: An Algorithmic Perspective (Chapman & Hall/Crc Machine Learning & Patrtern Recognition)

Machine Learning: An Algorithmic Perspective (Chapman & Hall/Crc Machine Learning & Patrtern Recognition)